章节大纲

-

平时成绩:30%,6 次平时测验(选择题为主,实验课时先测验再做实验)、考勤

6 次测试内容

test1 01020304讲 test2 0506 讲 test3 0708 讲 test4 091011121317讲 test5 141516 讲 test6 181920 讲 Previous midterms are available: Without solutions: Spring 2013, Spring 2014, Spring 2015, Fall 2015, Spring 2016, Spring 2017, Spring 2019, Summer 2019, Spring 2020 Midterm A, Spring 2020 Midterm B, Spring 2021, Spring 2022, Spring 2023, Spring 2024. With solutions: Spring 2013, Spring 2014, Spring 2015, Fall 2015, Spring 2016, Spring 2017, Spring 2019, Summer 2019, Spring 2020 Midterm A, Spring 2020 Midterm B, Spring 2021, Spring 2022, Spring 2023, Spring 2024.

Previous final exams are available. Without solutions: Spring 2013, Spring 2014, Spring 2015, Fall 2015, Spring 2016, Spring 2017, Spring 2019, Spring 2020, Spring 2021, Spring 2022, Spring 2023, Spring 2024. With solutions: Spring 2013, Spring 2014, Spring 2015, Fall 2015, Spring 2016, Spring 2017, Spring 2019, Spring 2020, Spring 2021, Spring 2022, Spring 2023, Spring 2024.

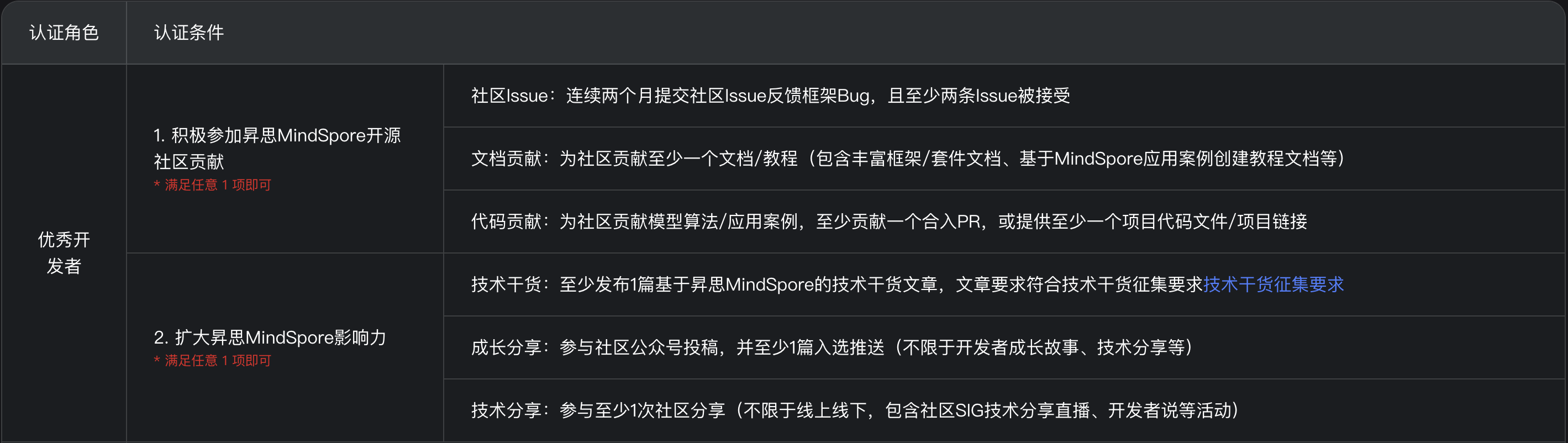

平时成绩加分:新出或测试上述题库质量的题目,每个题目平时成绩加1分;申请 mindspore 在线实习https://www.mindspore.cn/internship并完成任意积分任务平时成绩加到满分(平时成绩100分加满为止)。通过PR合并申请认证优秀开发者平时成绩加到满分,其他加5分https://www.mindspore.cn/developers/#applicationProcess。;翻转课堂或复习课加分待定

考勤主要由 test 是否参加体现。

期末考试:70%

1.传统机器学习24分 模型评估(AB 卷必考)、朴素贝叶斯、SVM、集成学习、PCA、K-Means(AB 卷分别 5 考 2)

2.DNNCNN 24分 (传统机器学习的 梯度下降、逻辑回归、感知机通常合并在此考)

3.RNN 16分

4. Transformer 16分

5. 实验程序填空题 20分 :https://www.mindspore.cn/tutorials/zh-CN/r2.2/beginner/train.html 考 10 分代码填空 (AB 卷均考)

ex04 SSD A 卷 10 分 ex05 Seq2Seq B 卷10 分。

题库:同平时测验(大题为主)

算法 模型假设 损失函数 优化方法 朴素贝叶斯 特征条件独立(给定类别下特征独立) 对数似然损失(最大似然估计) 极大似然估计(或EM算法处理缺失值) SVM 数据线性可分(或通过核函数映射到高维可分),最大化分类间隔 Hinge Loss + L2正则化项 拉格朗日对偶 + SMO(序列最小优化) 集成学习 - 随机森林:特征子集独立性

- GBDT:残差逐步拟合- 随机森林:基尼系数/信息增益

- GBDT:自定义损失(如平方损失、对数损失)- 随机森林:Bagging

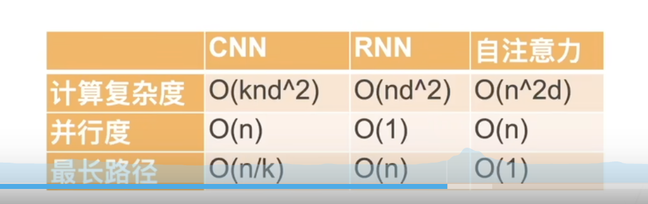

- GBDT:梯度下降(加法模型)PCA 数据在低维线性子空间上方差最大 重构误差最小化(或协方差矩阵特征值最大化) 特征值分解(或SVD) K-Means 数据呈球形分布,簇内紧密 样本到簇心的平方距离和(SSE) EM算法(迭代更新簇心与样本分配) 逻辑回归 数据线性可分,通过sigmoid映射概率 交叉熵损失(对数损失) 梯度下降(或拟牛顿法) 线性回归 数据成线性分布 平方误差 最小二乘/随机梯度下降 DNN 多层非线性变换可拟合复杂函数 任务相关(如交叉熵、均方误差) 反向传播 + 梯度下降变体(如Adam、SGD) CNN 局部相关性、平移不变性(通过卷积核和池化) 任务相关(如交叉熵) 反向传播 + 梯度下降变体(如Adam) RNN 序列数据的时间依赖性(通过循环结构传递状态) 交叉熵(序列预测任务) BPTT(随时间反向传播)+ 梯度截断/Adam Transformer 全局依赖关系通过自注意力机制捕获 交叉熵(带掩码的序列预测任务) Adam优化器 + 学习率预热(如Noam调度) 实验课:代码及报告85% 实验课讲题\答辩15% 可选任务加分移植ipynb到modelarts AI Gallery 5%(必须LLM或Transformer相关,内容质量必须高于已有AI Gallery,推荐结合 Deepseek API ),迟交 24 小时扣 5%,超过 120 小时最高为 60%。实验加分:mindspore相关微认证 每个加2分。其他华为人工智能微认证每个加1分(实验加分最多 4 分)。https://edu.huaweicloud.com/certifications

-

- 以垃圾邮件分类为例,出一道查准率(precision).查全率(recall)的计算题。试述真正例率(TPR).假正例率(FPR)与查准率(precision).查全率(recall)之间的关系。出一道多项选择题。

- 写出绘制PR曲线的伪代码

- 模仿教材例题 4.1 更改数值。出计算填空题。

- 模仿教材例题 7.1 让学生利用几何方法直接求 svm最 ⼤ 间 隔 分 离 超 平面方程。多选题。

- 模仿教材例题 7.2 更改点坐标 让学生 计算对偶问题展开化简过程。出填空题。

- svm 求解分几步。出排序题。

- 出一道多项选择题,下面哪些问题是凸优化问题。

- 出一道多选题,svm 对偶问题的 KKT 条件,下面给出的哪些是正确的?给 10 个选项条件 诺干错 剩余对。

- 模仿教材 例题 5.2 更改数值后 出一道填空题 随机考一种属性划分 计算信息增益 ;不用让他们重复计算每一种划分。

- 算法 5.2 出一道 排序题

- 算法 5.3 出一道 排序题

- 模仿教材 例题 5.4 更改数值后 出一道填空题 随机考一种属性划分 计算Gini;不用让他们重复计算每一种划分

- 出一道 6 个选项的单选题,给定一个比较明显的数据,让学生用 ID3 生成决策树,选择正确的树。主要考察学生对决策树算法的理解,即使不计算数值,也能估算最后的决策树。

- 模仿教材 例题 8.1 更改数值后 出一道填空题 挖多个空 考一次更新权重过程即可

- 出一道 计算 题 考d2l教材公式6.3.2

- 已知模型网络架构 求上述模型参数量

- RNN 会考去年试卷 同类型计算题